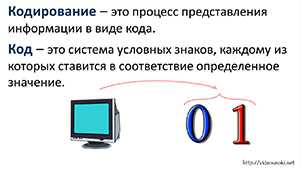

Кодирование играет ключевую роль в мире информатики и компьютерных технологий. Это процесс преобразования информации в формат, понятный компьютерам и другим электронным устройствам. Стютсем сказать, кодирование — это способ коммуникации между человеком и машиной.

Вместо использования обычных слов и символов, которые мы обычно используем для общения, кодирование использует бинарный код — последовательность единиц и нулей. Каждый символ, число или даже цвет кодируется определенным образом.

Примером кодирования может быть ASCII — стандартная система кодирования символов, используемая в большинстве компьютерных систем. Она преобразует каждый символ в соответствующий числовой код, который затем может быть интерпретирован компьютером.

- Определение кодирования

- Значение кодирования в информатике

- Принципы кодирования

- 1. Единство кодирования

- 2. Надежность кодирования

- 3. Эффективность кодирования

- 4. Масштабируемость кодирования

- Различные методы кодирования

- Заключение

- Вопрос-ответ:

- Зачем в современных технологиях используется кодирование?

- Какие методы кодирования применяются в современных технологиях?

- Какое место занимает кодирование в развитии современных технологий?

Определение кодирования

Когда мы отправляем сообщение через Интернет или сохраняем фотографию на нашем компьютере, они хранятся в виде байтов, нулей и единиц. Кодирование помогает нам перевести эти данные в понятную для компьютера форму. Но кодировать можно не только текст и изображения, но и звук, видео, а также любые другие типы данных.

Кодирование имеет ряд применений и важность в информатике и компьютерной науке. Оно позволяет создавать стандарты для обмена информацией, защищать данные путем шифрования, а также сжимать файлы, чтобы они занимали меньше места.

В основе кодирования лежит использование различных систем и алгоритмов. Одни из самых известных систем кодирования в информатике — ASCII, Unicode и UTF-8. Они определяют, как символы, цифры и специальные символы будут представлены в бинарном коде.

Таким образом, кодирование является ключевым аспектом информатики, который позволяет нам работать с различными типами данных. Благодаря кодированию, мы можем обмениваться информацией, защищать данные и создавать невероятные вещи в мире технологий.

Значение кодирования в информатике

Представьте, что вы хотите отправить фотографию другу через Интернет. Но как передать эту фотографию компьютеру? Решение заключается в кодировании. Путем применения определенного алгоритма фотография преобразуется в последовательность битов, состоящую из нулей и единиц. В результате получается файл, который компьютер может понять.

На практике существуют различные методы кодирования, такие как ASCII, UTF-8, Base64 и многие другие. Каждый из них имеет свои особенности и преимущества в зависимости от задачи.

Кодирование играет важную роль во всех сферах информатики, от создания веб-страниц и приложений до передачи данных по сети. Без кодирования мы не могли бы обмениваться информацией с такой легкостью и эффективностью, как сегодня.

Так что, следующий раз, когда вы отправляете сообщение или фотографию через Интернет, помните о значении кодирования и то, как оно упрощает нашу жизнь в цифровой эпохе.

Принципы кодирования

1. Единство кодирования

Принцип единства кодирования состоит в том, чтобы использовать одну и ту же систему кодирования для всех видов информации. Например, для хранения и передачи текста, звука и изображений можно использовать кодировку UTF-8, которая позволяет представить любые символы в виде последовательности байт.

2. Надежность кодирования

Принцип надежности кодирования заключается в использовании способов кодирования, которые минимизируют возможные ошибки при передаче или хранении информации. Например, при передаче данных по сети применяется метод контрольных сумм, который позволяет обнаруживать ошибки и восстанавливать поврежденные данные.

3. Эффективность кодирования

Принцип эффективности кодирования состоит в том, чтобы передавать и хранить информацию с минимальными затратами ресурсов. Например, можно использовать сжатие данных для уменьшения объема передаваемой или сохраняемой информации.

4. Масштабируемость кодирования

Принцип масштабируемости кодирования предусматривает возможность расширения системы кодирования для поддержки новых типов информации. Например, если в начале кодирование предусматривает только текст, в дальнейшем систему можно расширить для поддержки звука, изображений и других медиа-форматов.

Таким образом, принципы кодирования играют важную роль в информатике, позволяя эффективно обрабатывать и передавать информацию в различных форматах.

Различные методы кодирования

Когда речь идет о кодировании, существует множество различных методов, которые используются для преобразования информации в более удобный для хранения или передачи формат. Некоторые из наиболее распространенных методов включают символьное кодирование, двоичное кодирование и сжатие данных.

Символьное кодирование — это метод, который преобразует символы в числа или другие символы. Например, ASCII — один из самых распространенных методов символьного кодирования, где каждой букве, цифре или символу присваивается соответствующее числовое значение.

Двоичное кодирование — это метод, который преобразует информацию в двоичный формат, используя только две цифры: 0 и 1. Это основа для работы компьютеров, так как они используют двоичную систему счисления. В двоичном кодировании каждому символу присваивается уникальный двоичный код.

Сжатие данных — это метод, который уменьшает размер информации, удаляя избыточность или повторяющиеся элементы. Это полезно для экономии пространства на диске или для ускорения передачи данных через сеть. Существуют различные алгоритмы сжатия данных, такие как ZIP или GZIP, которые сжимают информацию без потери качества.

Важно понимать, что выбор метода кодирования зависит от конкретной задачи и требований. Некоторым методам требуется больше пространства для хранения или передачи информации, но они могут обеспечивать более высокую точность и надежность. Другие методы могут быть менее точными, но более эффективными в использовании пространства или передаче данных. Поэтому важно выбирать метод кодирования, который наилучшим образом соответствует конкретным требованиям.

Заключение

Кодирование в формате HTML позволяет создавать структурированные и информативные веб-страницы с использованием различных тегов и атрибутов. Оно позволяет представить информацию в удобном и понятном для пользователя виде, а также обеспечивает возможность взаимодействия и обмена данными между сервером и клиентом.

Кроме того, кодирование нашло применение и в других современных технологиях, таких как компьютерное зрение, искусственный интеллект, машинное обучение и даже генетическое программирование. Оно открывает новые возможности и перспективы и помогает развиваться и совершенствоваться в эпоху цифровых технологий.

Таким образом, кодирование играет важную роль в современных технологиях, обеспечивая передачу, хранение и обработку информации. Без него было бы невозможно создание сложных программ и систем, которые сегодня широко используются в разных сферах деятельности. Владение навыками кодирования является одним из ключевых требований для специалистов информационных технологий и позволяет успешно участвовать в цифровой эпохе.

Вопрос-ответ:

Зачем в современных технологиях используется кодирование?

Кодирование применяется в современных технологиях по нескольким причинам. Во-первых, оно позволяет преобразовывать данные из одной формы в другую, что упрощает их передачу и хранение. Во-вторых, кодирование обеспечивает защиту информации, позволяя шифровать данные и предотвращать несанкционированный доступ к ним. Также, кодирование позволяет сжимать данные, что помогает экономить пропускную способность сети и уменьшать объем хранимой информации.

Какие методы кодирования применяются в современных технологиях?

В современных технологиях используется множество методов кодирования. Некоторые из них включают символьное кодирование, числовое кодирование, кодирование аудио и видео данных, кодирование с использованием модуляции сигнала, кодирование с использованием сетевых протоколов и другие. Конкретный метод кодирования выбирается в зависимости от конкретной задачи и требований к передаче и хранению данных.

Какое место занимает кодирование в развитии современных технологий?

Кодирование имеет значимое место в развитии современных технологий. Без кодирования было бы невозможно передавать, хранить и обрабатывать большие объемы данных, так как оно обеспечивает эффективность и безопасность обмена информацией. Кроме того, кодирование является основой для разработки новых технологий, таких как искусственный интеллект, интернет вещей и блокчейн. В общем, кодирование играет важную роль в различных областях науки и технологий.